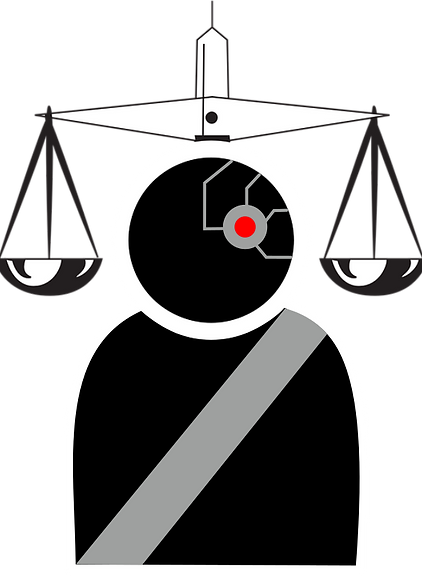

L'IA telle qu'elle est théorisée pose de nombreux problèmes juridiques. Il s'agirait d'un logiciel évolutif, créé par quelqu'un pour accomplir une tâche. Du point de vue de la loi, on pourrait résumer cela à un simple programme, que l'on laisse tourner en autonomie une fois créé.

Cela soulève plusieurs problèmes :

-

Qui est responsable en cas d'accident impliquant l'IA ?

La loi nous dit "On est responsable non seulement du dommage que l'on cause par son propre fait, mais encore de celui qui est causé par le fait des personnes dont on doit répondre, ou des choses que l'on a sous sa garde" (http://www.ejuris-consult.be/gardien-chose-responsabilite.shtml).

Mais la notion de "garde" n'est pas pertinente lorsqu'on parle d'IA. En effet l'IA est autonome, et agit sans surveillance ni contrôle extérieur ; on ne peut donc pas imputer à l'utilisateur la faute commise par L'IA.

La solution de facilité serait de considérer le fabriquant comme responsable, mais cela n'est possible que si l'IA présente un dysfonctionnement avéré. Si l'accident résulte de la simple utilisation de l'IA, le fabricant ne peut être mis en cause. "A l'heure actuelle, le droit de la responsabilité du fait des produits défectueux ne permet pas de répondre à ces questions ni de savoir qui serait responsable en cas de dommage causé par un robot autonome." (http://www.legavox.fr/blog/maitre-anthony-bem/robots-pourraient-etre-responsables-leurs-12530.htm#.WL_MPHornQI)

On pourrait alors se retourner contre le programmeur qui a créé l'IA. Malheureusement l'IA n'est pas un simple logiciel, elle est composée d'algorithmes qui lui permettent de résonner. Or selon le CNRS les éléments du logiciel non protégés par le droit d'auteur sont : "les fonctionnalités, les algorithmes, les interfaces, les langages de programmation". (http://www.dgdr.cnrs.fr/daj/propriete/logiciels/logiciels2.htm)

Ainsi, les algorithmes qui indirectement permettent la faute ne sont pas soumis au droit d'auteur, et n'engagent donc pas la responsabilité du programmeur.

-

Jusqu'où peut-on aller dans l'analyse des objets connectés dans le cadre d'affaires judiciaires?

Pour l'instant, nous utilisons (à tort) le terme IA pour définir les différents objets connectés qui peuplent notre quotidien. Même très éloignés de ce qu'est une véritable IA, ces dispositifs peuvent eux aussi créer un imbroglio juridique lors qu'ils se trouvent sur le chemin de la justice. Par exemple, une sordide affaire de meurtre a été résolue à Bentonville (Arkansas) grâce à l'Echo d'Amazon, un dispositif domotique permettant de piloter une maison connectée. L'Echo fonctionnant par commande vocale, l'analyse de ses enregistrements ont permis à la police de dénouer l'affaire, alors que l'absence de témoins rendait celle-ci délicate. Mais ceci ne fût possible qu'après un long bras de fer entre la police et Amazon, l'entreprise refusant l'accès aux données personnelles de son client, par respect pour sa vie privée. ( https://www.franceculture.fr/emissions/la-vie-numerique/quand-une-machine-est-temoin-dun-meurtre-cest-complique?xtmc=internet+juridique&xtnp=1&xtcr=11 )

L'OBS Rue 89 nous rapporte une autre histoire édifiante. Aux Etats-Unis, une femme est réveillée en pleine nuit chez elle par un intrus qui la menace avec un couteau et la viole au terme d'une rixe durant laquelle elle perd son bracelet électronique FitBit (mesurant l'activité physique et le sommeil). La femme porte plainte pour viol, mais l'analyse de son bracelet met à mal sa version des faits. Il est retrouvé intacte et a enregistré une séance de marche alors que la femme était censée dormir. Ces incohérences ont amené la justice américaine à inculper la femme pour altération de preuves et fausse déclaration. ( http://tempsreel.nouvelobs.com/rue89/rue89-connexions-dangereuses/20150701.RUE9709/justice-quand-les-objets-connectes-temoignent-contre-vous.html )

Mais cet article nous met également en garde sur la fiabilité de tels objets. Il est dangereux de prendre les données de ces appareils pour argent comptant, tant ils sont pragmatiques dans leur collecte de données : "Il suffit de le faire porter par un complice ou de l’apposer à un animal domestique au comportement pas trop erratique. Ou encore de rester assis à son bureau en bougeant les pieds très vite pour faire croire qu’on fait un jogging."

Depuis 2006 la firme Sud Coréenne Samsung fabrique un modèle de robot militaire nommé SGR-A1. Il est employé dans la surveillance de sites stratégiques, ainsi que pour garder la zone coréenne démilitarisée. (https://fr.wikipedia.org/wiki/Samsung_SGR-A1)

La création et l'emploi de Systèmes d'Armement Létaux Automatisés (SALA) est limité par le Droit International Humanitaire comme suit:

- Un SALA ne dois pas causer de maux superflus.

- Un SALA dois pouvoir mettre une cible hors de combat sans rendre sa mort inévitable.

- Les armes utilisées par un SALA doivent être discriminantes, les armes frappant sans distinction les objectifs civiles et militaires sont strictement interdites.

- Les armes interdites par les conventions internationales le sont aussi pour les SALA.

(http://www.memoireonline.com/11/13/7823/m_Lutilisation-des-robots-militaires-dans-les-conflits.html)